Une publication dans eNeuro pour INVIBE

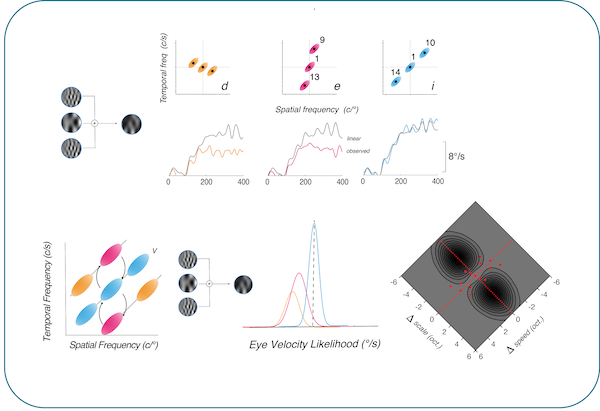

Estimer la vitesse à laquelle se déplace une proie, un objet ou encore un véhicule est indispensable pour pouvoir contrôler nos actions dans un environnement dynamique. Or on comprend toujours mal comment les systèmes visuels biologiques réalisent cette estimation malgré les nombreuses incertitudes qui affectent les signaux de mouvement visuel. Dans la suite de notre article publié dans Current Biology en 2017 (Gekas et al., 2017), nous avons identifié les règles computationnelles qui permettent cette estimation dans le contexte des mouvements oculaires de poursuite. Pour cela, nous avons présenté aux participants des réseaux de luminance ou des textures naturelles en mouvement dont la moyenne, mais non la variance, des caractéristiques spatiales et temporelles correspondait. Les mouvements oculaires enregistrés dépendaient du type de stimulus, avec des estimations de vitesse plus fiables pour les entrées naturalistes. Les réponses oculaires à des motifs composés de plusieurs éléments ont évolué sur ∼200 ms, passant d’une intégration linéaire à une intégration non linéaire de l’information. La non-linéarité révélée par notre travail de modélisation suggère des processus inhibiteurs et excitateurs simultanés agissant au sein d’une représentation du mouvement qui encode la vitesse du stimulus (le rapport des fréquences temporelle et spatiale) et l’échelle (le produit des fréquences temporelle et spatiale) comme dimensions clés. Ce cadre vitesse-échelle reformule les approches classiques des canaux spatio-temporels pour jeter une nouvelle lumière sur les calculs d’intégration et de segmentation du mouvement aux niveaux neuronal et comportemental.

Ce travail a été réalisé en collaboration avec Pascal Mamassian (LPS, ENS/CNRS, Paris), Andrew Meso (King’s College, Londres) et Nikos Gekas (Napier University, Edinburgh).

Andrew Isaac Meso, Nikos Gekas, Pascal Mamassian and Guillaume S. Masson (2022) Speed Estimation for Visual Tracking Emerges Dynamically from Nonlinear Frequency InteractionseNeuro 25 April 2022, 9 (3) ENEURO.0511-21.2022; DOI: https://doi.org/10.1523/ENEURO.0511-21.2022https://www.eneuro.org/content/9/3/ENEURO.0511-21.2022